Tutoriels de Pythonia

Guides, IA, tutos et newsletter pour devenir une bête en programmation

Mis à jour le Aug. 4, 2023, 11:58 a.m.

PrivateGPT est un outil puissant qui vous permet d'interroger des documents localement sans avoir besoin d'une connexion Internet. Cet article vous guidera à travers le processus d'installation et de configuration de PrivateGPT. PrivateGPT permet d'interroger des documents localement sans avoir besoin d'une connexion Internet. Que vous soyez chercheur, développeur ou simplement curieux d'explorer les outils d'interrogation de documents, PrivateGPT fournit une solution efficace et sécurisée.

1- Prérequis

2- Créer son environnement virtuel

3- Installer GIT

4-Télécharger le LLM de votre choix

5- Travailler sur vos propres documents

6- Accelerer le temps de réponse

Prérequis: Assurez vous d'avoir une version Python 3.10 ou plus

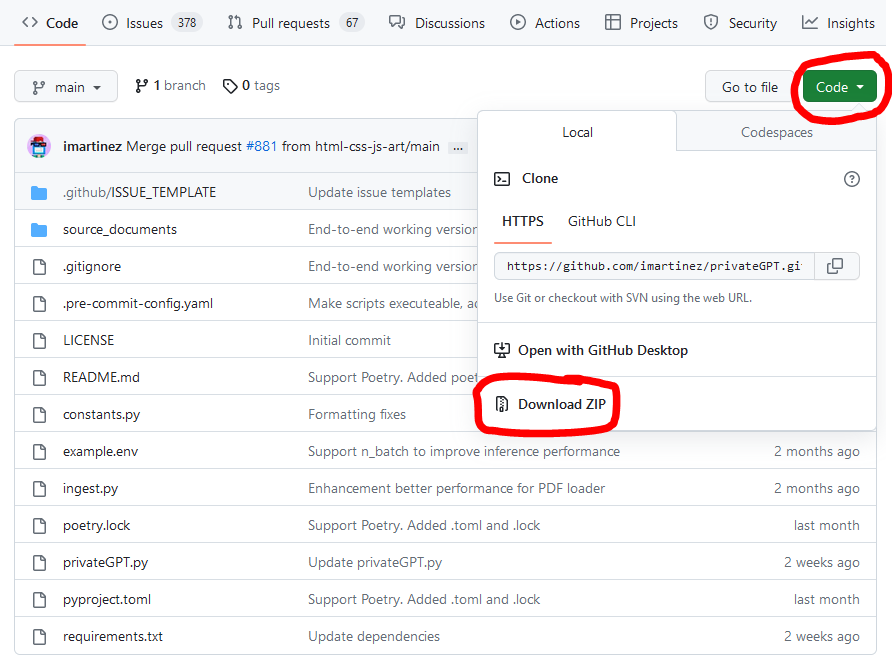

Aller chercher le code sur Github (cloner le repo)

Pour commencer, rendez vous sur le lien suivant https://github.com/imartinez/privateGPTqui contient PrivateGPT.

Une fois sur Github, télécharger le code comme ceci si vous n'avez pas git installé. Si vous souhaitez l'installer avant de commencer le tutoriel, allez ici.

Dézippez le fichier dans l'emplacement de votre choix. Ouvrez votre terminal

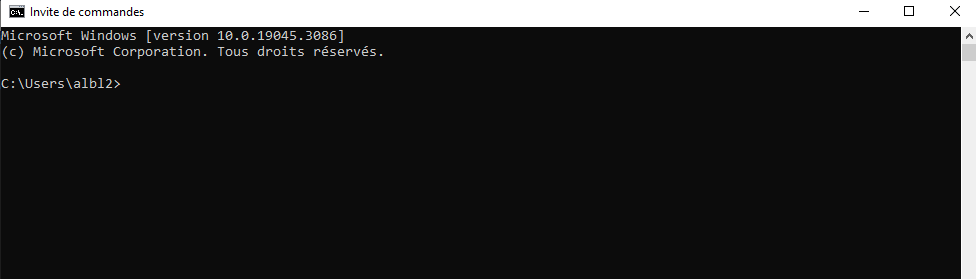

Ouvrez votre terminal

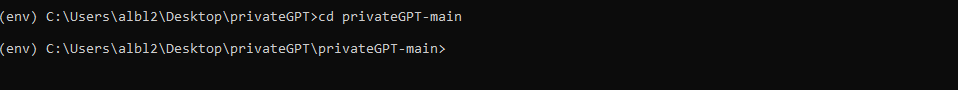

Déplacez vous dans le bon dossier

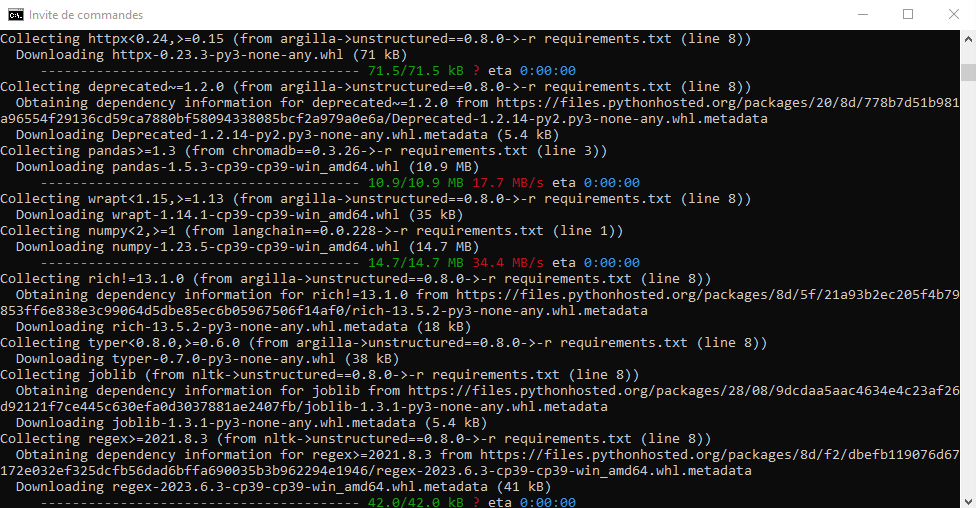

Installez les librairies suivantes

pip install virtualenv

pip install virtualenvwrapper-winAssurez vous que vous êtes bien dans le bon dossier puis lancez cette commande:

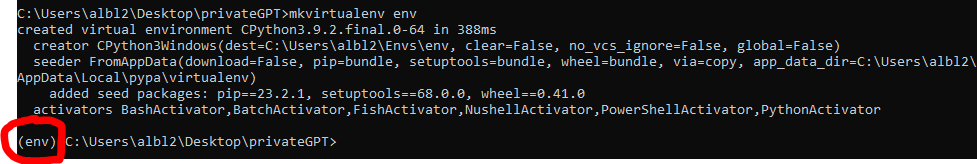

mkvirtualenv env

Vous devriez voir apparaître ceci:

L'environnement virtuel a bien été créé. On peut maintenant installé nos bibliotheques python

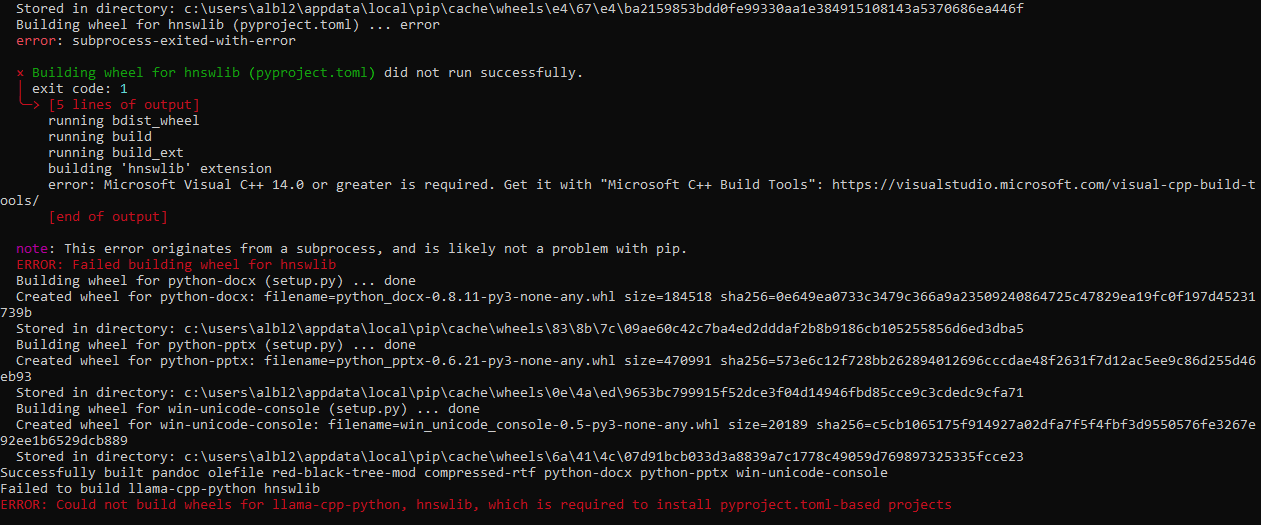

Si une erreur de ce genre apparait, c'est qu'il vous manque le compileur C++

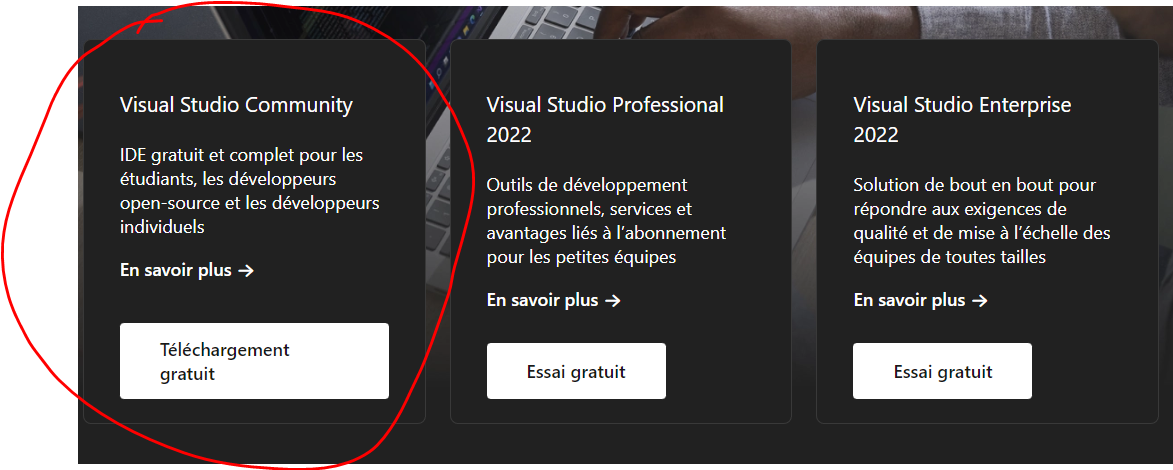

Pour résoudre cette erreur, veuillez télécharger le nécessaire ici: https://visualstudio.microsoft.com/fr/vs/community/

En bas de la page vous trouverez le téléchargement

Puis faites l'installation pour le developpment en C ++

Relancez la commande pip install -r requirements.txt

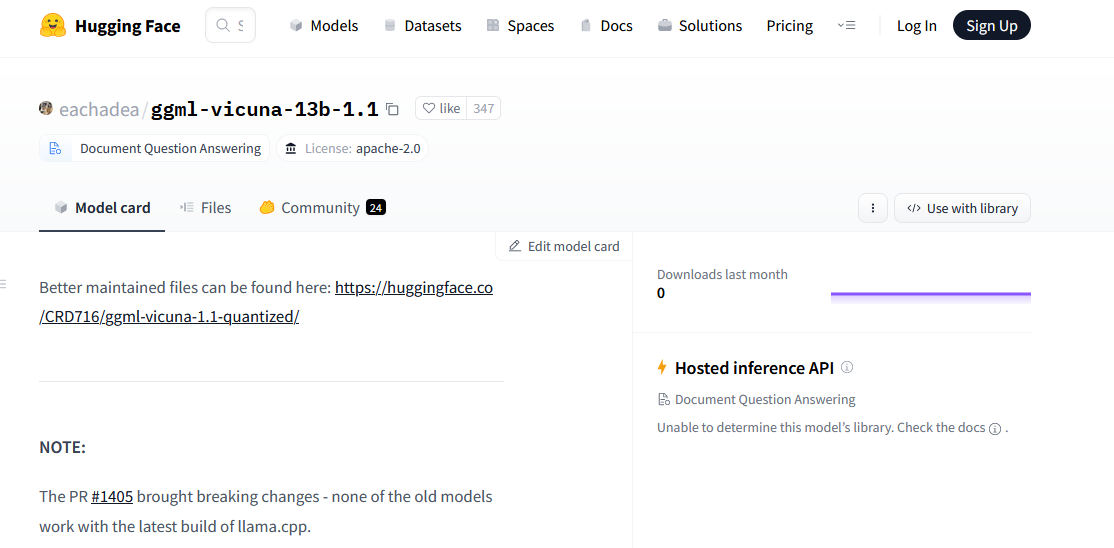

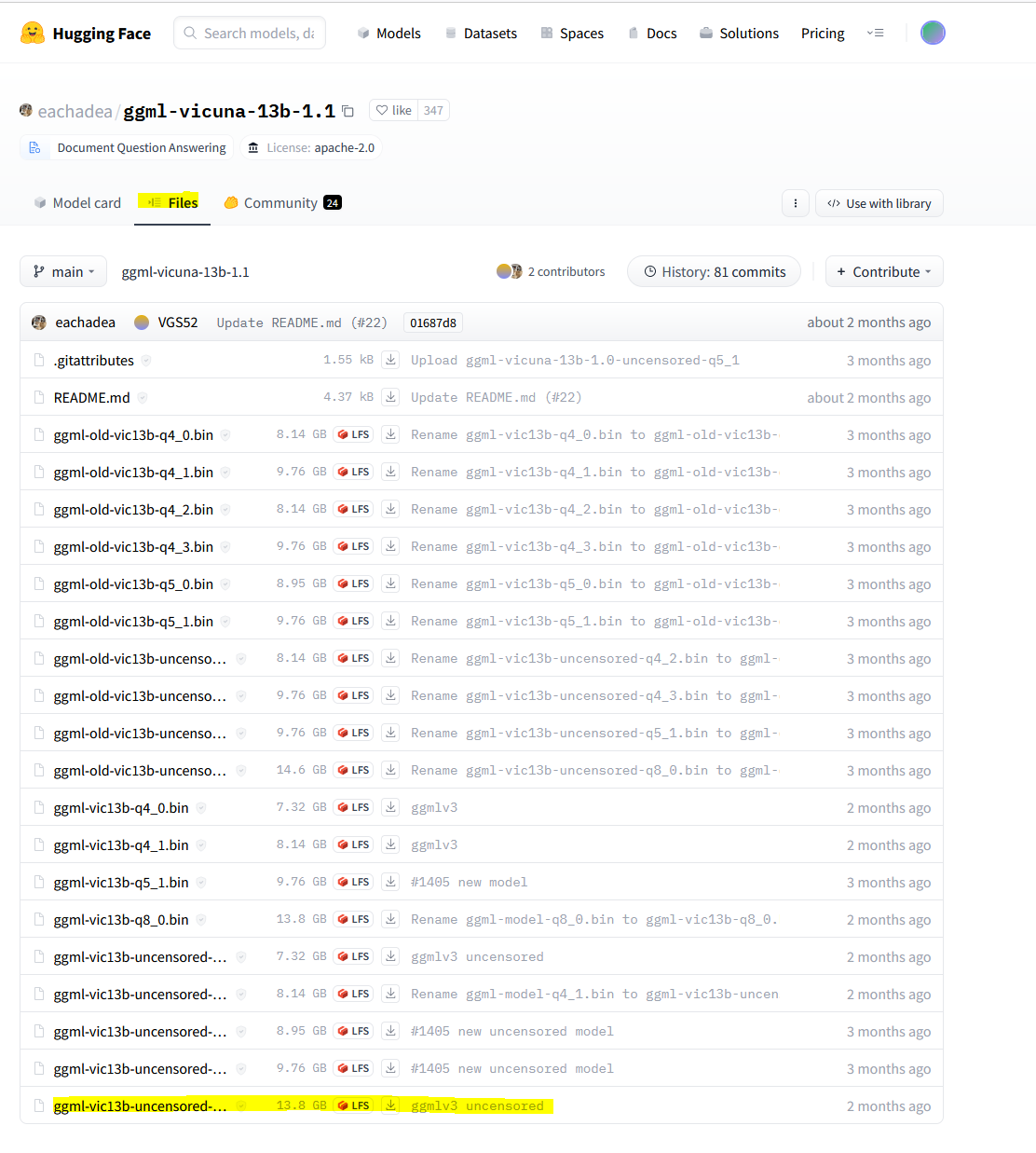

L' installation de GPT4all, qui est le type de model par default de chatgpt n'est pas très aisée. D'autres modèles tout aussi performants et moins gourmand en ressources sont disponible sur le site fantastique d'HuggingFace. Pour télécharger le modele que nous allons utiliser, rendez-vous ici: https://huggingface.co/eachadea/ggml-vicuna-13b-1.1

Vous aurez besoin d'être connecté pour télécharger le modele, créer un compte si vous n'en avez pas, c'est gratuit. Les modèles d'IA mis sur HuggingFace sont open source. Ils ont cependant chacun leur règles spécifiques, donc veuillez les lire si vous voulez aller plus loin qu'un simple usage personnel.

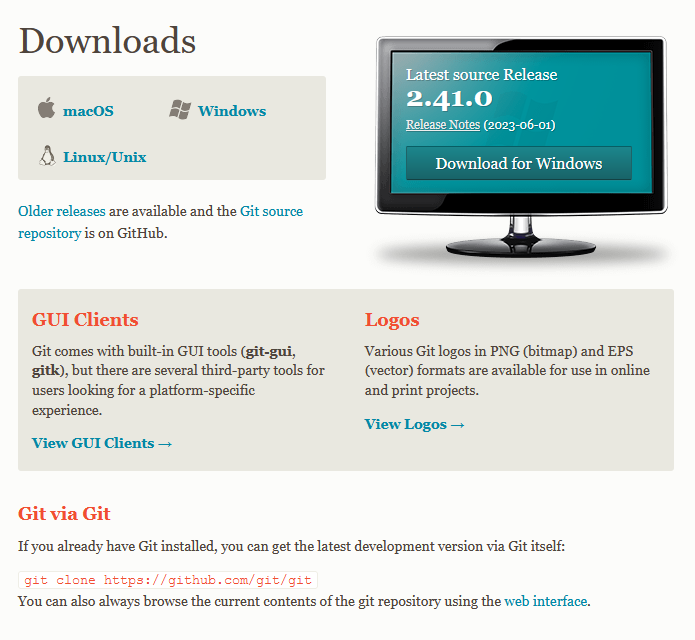

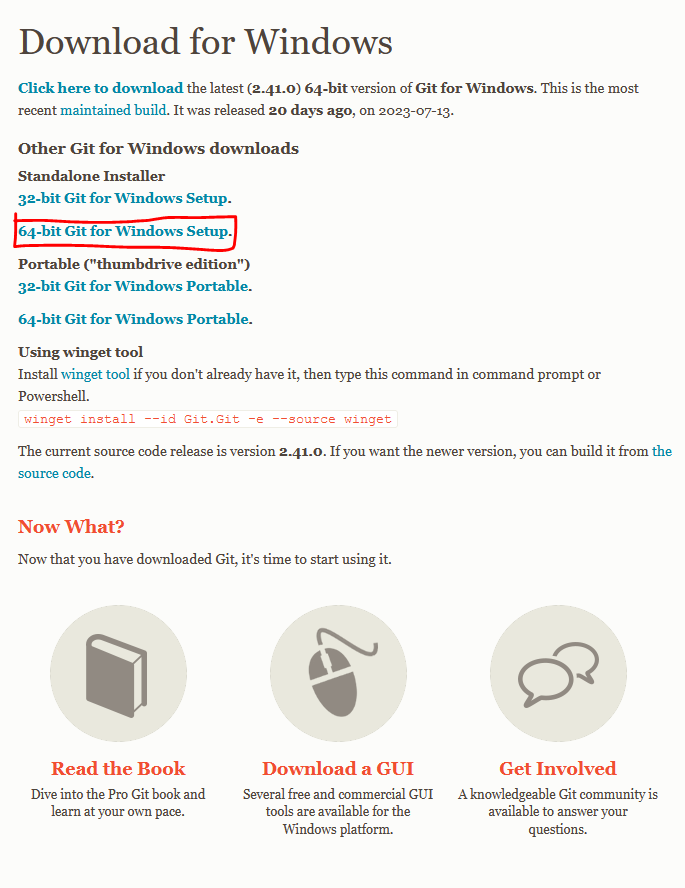

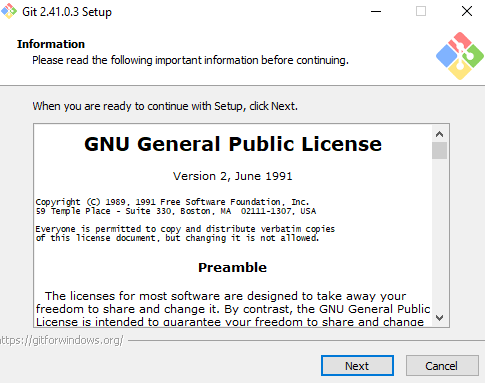

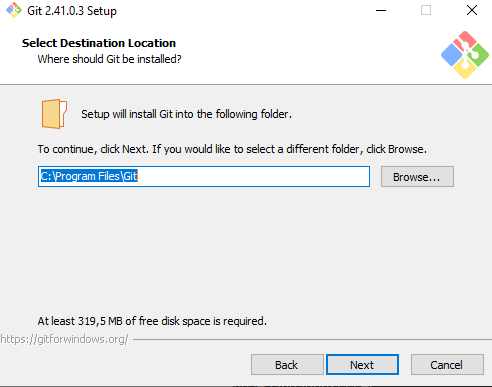

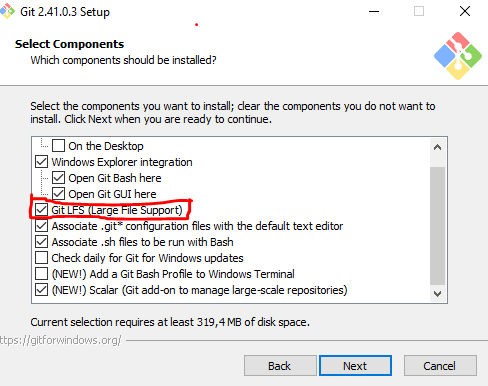

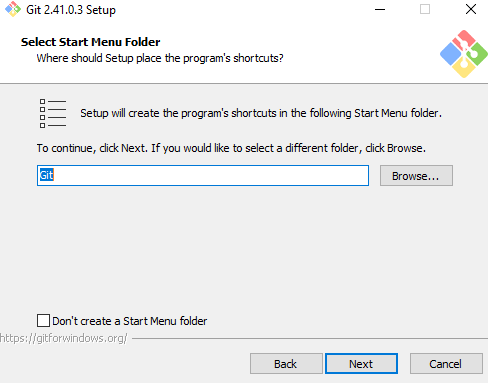

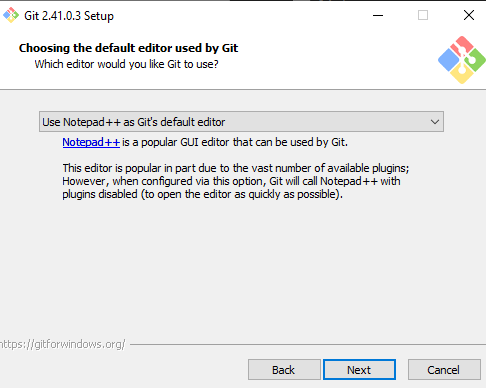

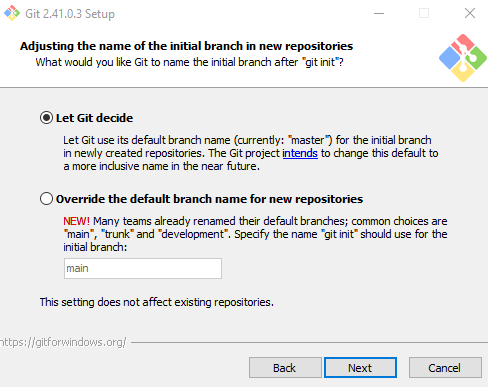

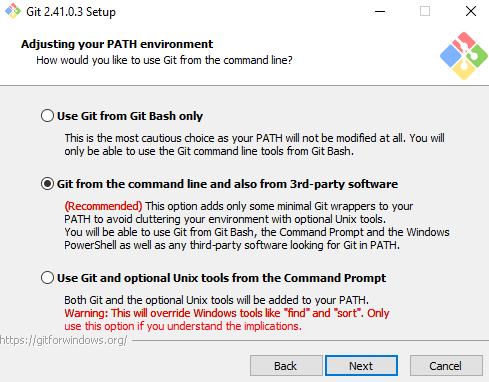

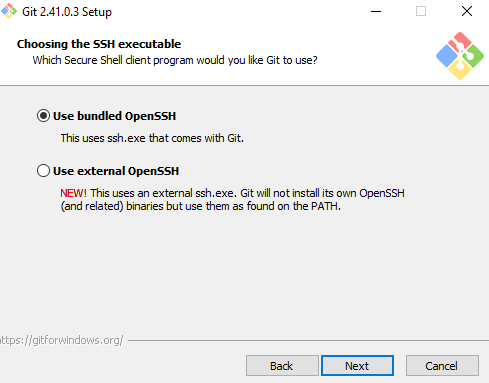

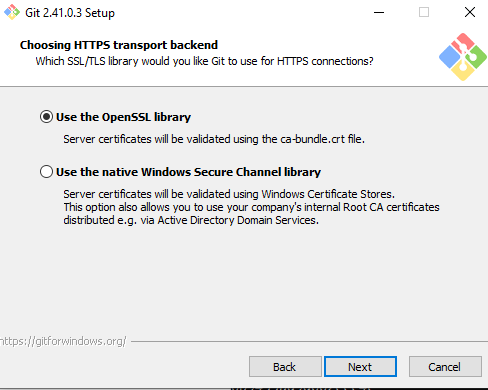

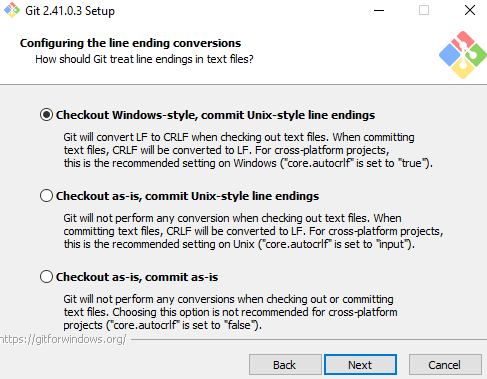

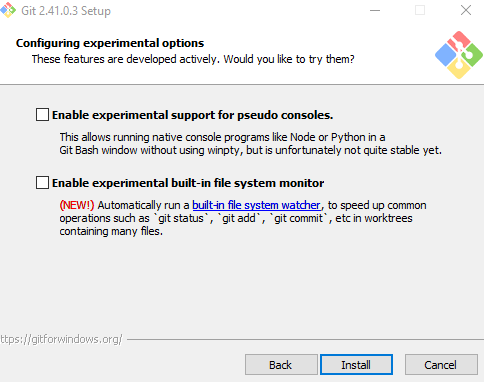

Si vous n'avez pas git: https://git-scm.com/downloads

Téléchargez la version correspondante. Je suis sous W10, je prends la version entourée en rouge

.

Et voilà, maintenant vous pouvez retourner dans votre terminal, et téléchargez le modèle. Enfin, pas tout à fait, il vous faut les lignes de commandes.

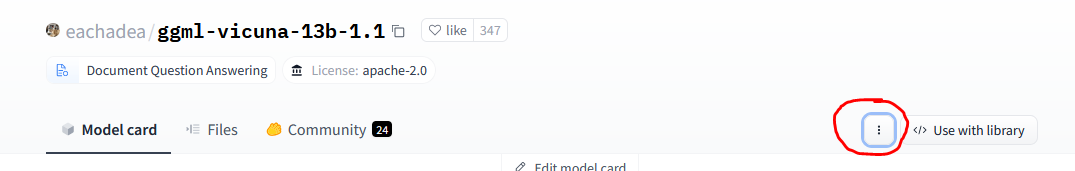

Elles se trouvent ici:

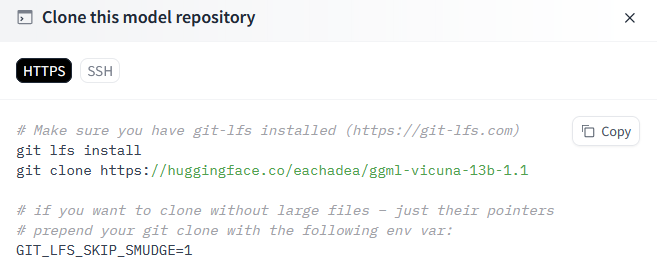

Cliquez sur 'Clone repository'. Cette fenêtre va apparaitre:

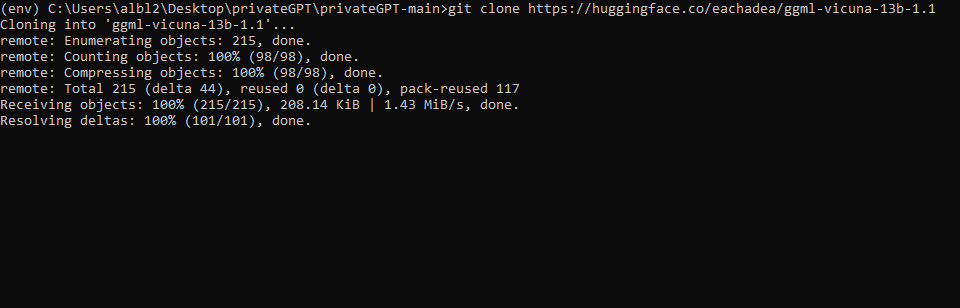

Prenez la deuxieme ligne et collez là dans votre terminal: git clone https://huggingface.co/eachadea/ggml-vicuna-13b-1.1

Si votre terminal ne vous indique rien pendant un certain temps c'est normal, soyez patient.

Solution alternative:

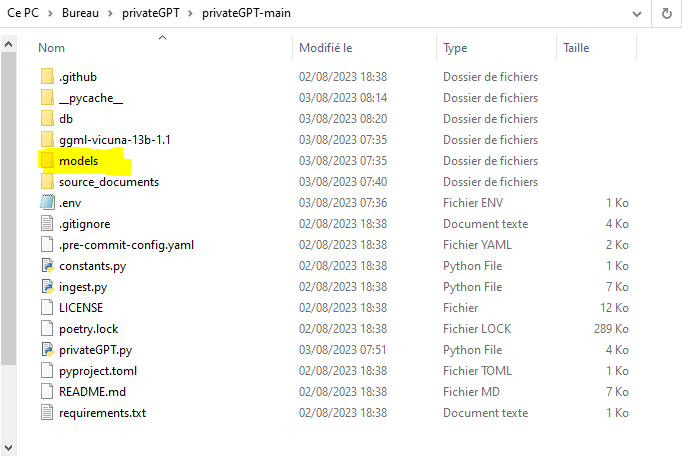

Créer un dossier 'Models'

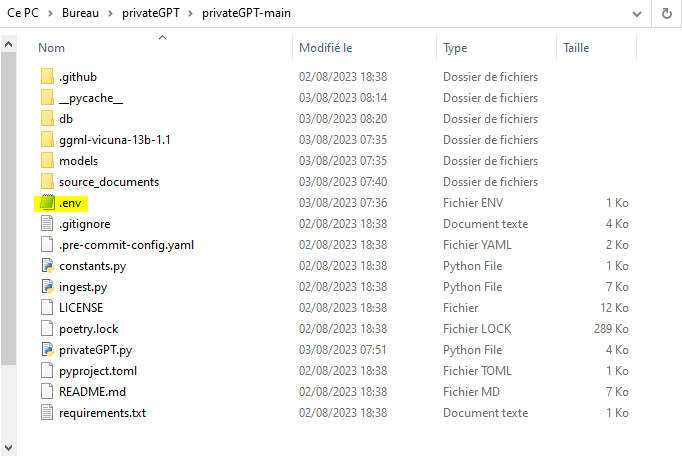

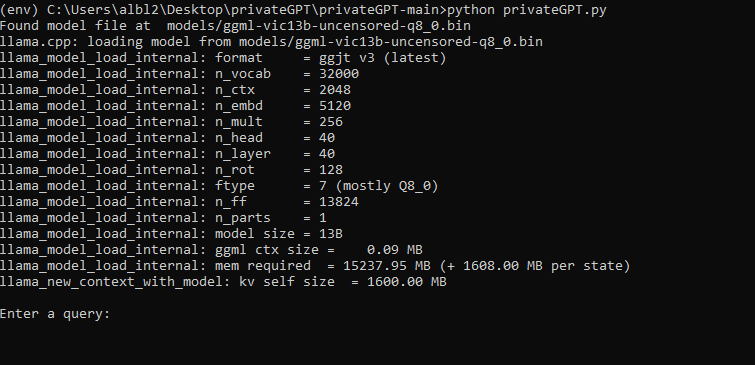

Renommez le fichier exemple.env en .env.

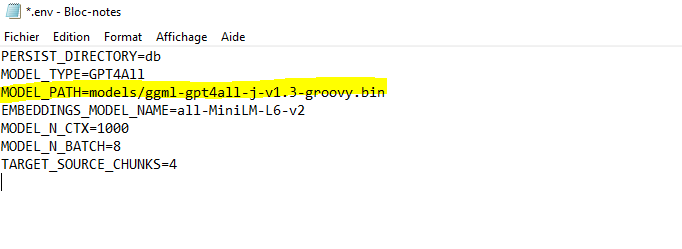

Ouvrez le fichier '.env' et remplacez cette ligne

par le nom de votre modele. Ici, notre modele s'appelle 'ggml-vic13b-uncensored-q8_0.bin'.

Enregistrez et fermez.

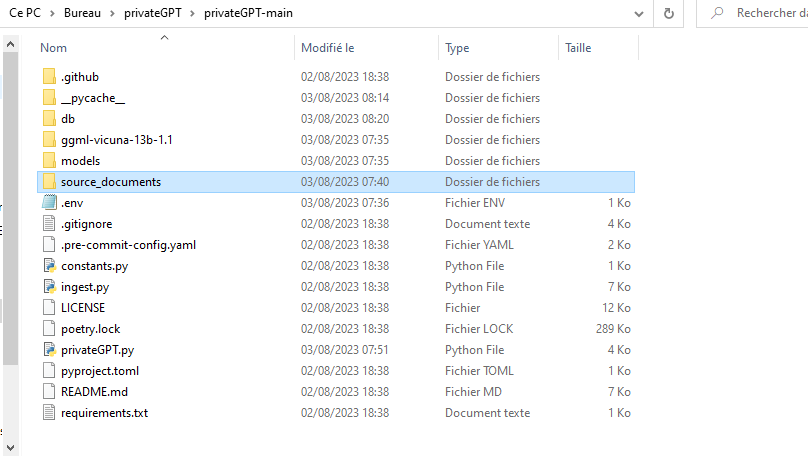

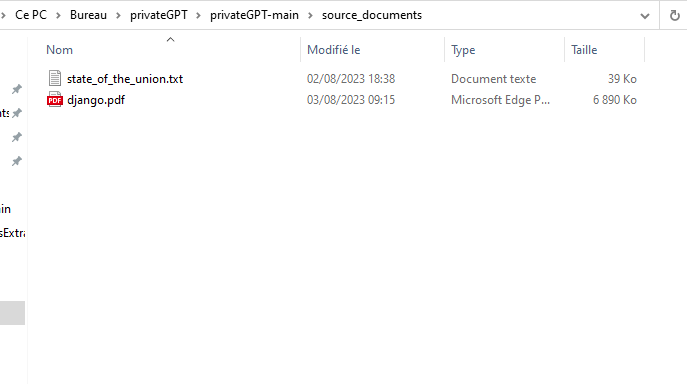

Prenez le document de votre choix et installez le dans le dossier intitulé 'source document'

Je vais pour ma part prendre la documentation PDF de django:

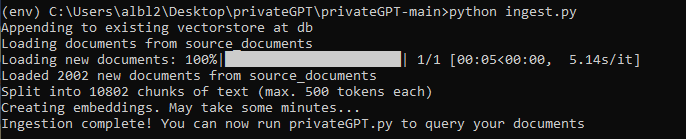

Bien, maintenant, il faut vectoriser ce pdf. Lancez cette commande:

python ingest.py

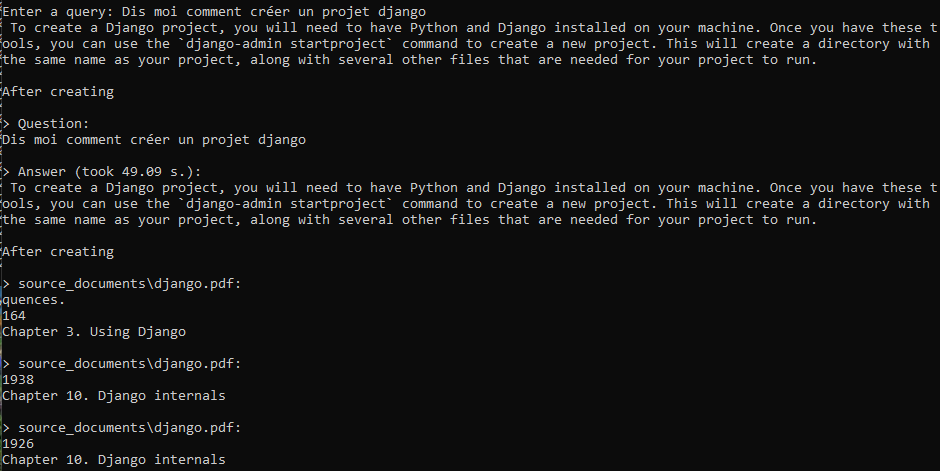

python privateGPT.py

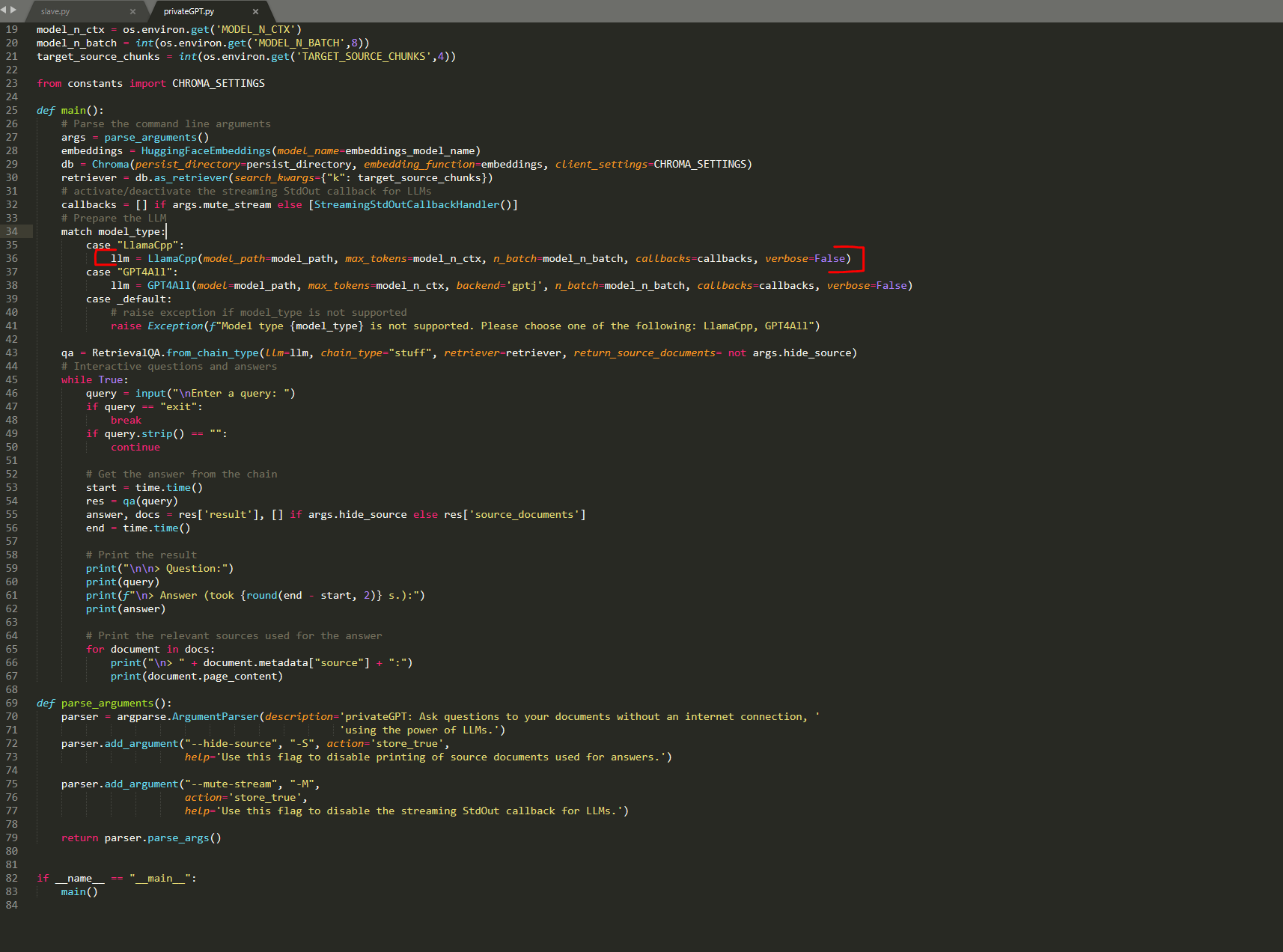

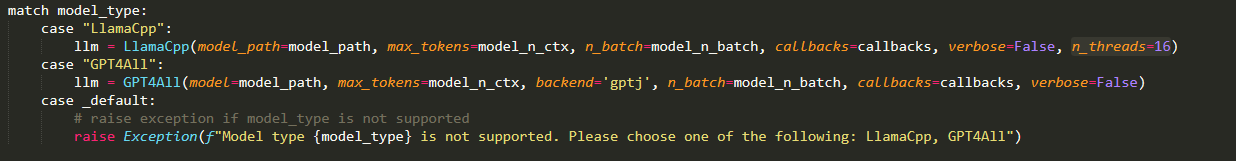

Vous l'aurez remarquer, le temps de réponse est un peu lent.

ouvrir privateGPT.py et rajouter un nombre de thread à la ligne 36

Rajoutez n_threads=16

# Python est la meilleure chose qui peut t'arriver. Quelque soit ton métier, apprends à le maîtriser #

Merci beaucoup pour ce tuto ! Je vais m'en servir au boulot. Franchement merci pour tout ce que tu donnes à la communauté !