Tutoriels de Pythonia

Guides, IA, tutos et newsletter pour devenir une bête en programmation

Mis à jour le Dec. 14, 2022, 9:04 a.m.

Dans ce tutoriel nous allons voir comment créer une application qui transforme le texte en image en utilisant l'algorithme Stable Diffusion.

1- Qu'est ce qu'Hugging Face?

2- Télécharger le modèle

3- Installation de Pytorch, Transformers et Diffusers

Hugging Face est une plateforme de données et de communauté qui fournit :

Des outils permettant aux utilisateurs de construire, d'entraîner et de déployer des modèles d'apprentissage automatique (ML) basés sur du code et des technologies open source.

Un lieu où une vaste communauté de scientifiques des données, de chercheurs et d'ingénieurs ML peuvent se réunir, partager des idées, s'entraider et contribuer.

Hugging Face répond à ce besoin en fournissant une "plateforme communautaire". C'est un lieu où n'importe qui peut partager et explorer des modèles et des ensembles de données. Autrement dit, il n'y a pas mieux pour s'amuser.

Nous n'allons pas entrainer le modèle de 0, mais plutôt nous servir d'un modèle existant pour l'intégrer à une application. J'ai réalisé ce tutoriel sous Ubuntu, mais je vous invite à tenter sous Windows 10. Si vous le faites sur votre machine vous devez avoir un environnement d'installé (pipenv, virtualenv ou autre) et avoir un setup de deep learning pour la computer vision déjà prêt à l'emploi (PIL, torch etc).

Enfin, je vous invite à le faire dans google colab si vous n'avez pas de GPU, ou un GPU trop peu puissant.

Tout d'abord, creez un compte sur Hugging Face: https://huggingface.co/

Vous arriverez sur une page de ce style qui vous demandera les informations classiques.

Il y a deux façons de faire pour pouvoir utiliser leur modèle préentrainé. Sois vous vous connectez directement avec l'API, soit vous cloner le github (nécessite d'être inscrit). Il y a certes un avantage à utiliser leur APIs, c'est que vous vous éviterez tout un tas de complications lié à l'installation, au MLOps etc. Cependant, si vous voulez vraiment toucher un peu du doigts l'IA, créer une appli sur votre propre serveur avec votre modèle, je vous conseille de télécharger le modèle, de l'installer et d'utiliser vos propres ressources (serveurs, machines etc). Les APIs c'est super, mais mieux vaut savoir en créer que les utiliser.

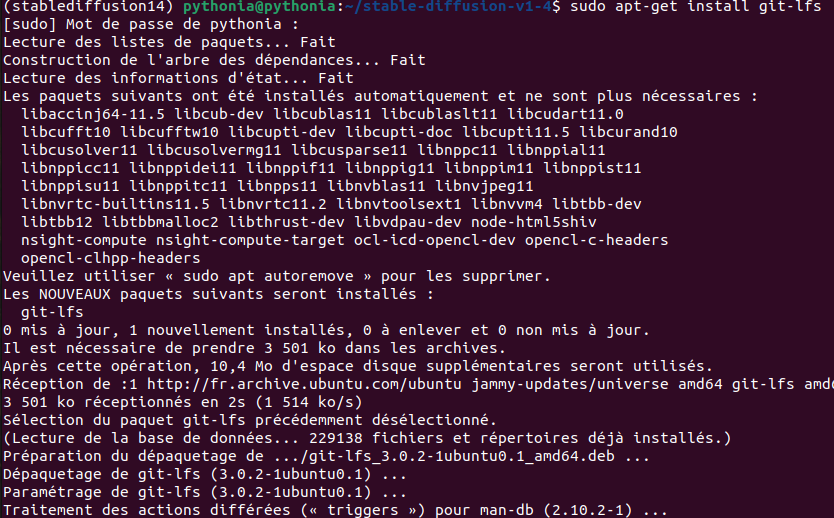

Avant de commencer, installer git-lfs:

sudo apt-get install git-lfs

Si ce n'est pas déjà fait, créez un environnement virtuel. J'appelerai le mien stablediffusion14.

mkvirtualenv stablediffusion14 -p python3

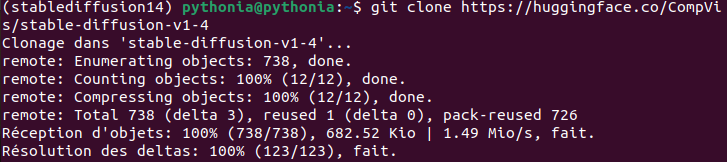

Lancez la commande suivante et entrez vos identifiants:

git clone https://huggingface.co/CompVis/stable-diffusion-v1-4

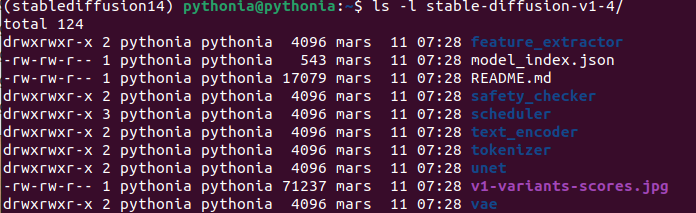

Vous devriez avoir un dossier nommé 'stable-diffusion-v1-4'

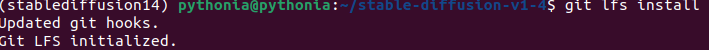

Installez git-lfs.

cd stable-diffusion-v1-4/

Lancez cette commande pour initialisé git.

git lfs install

Lancer la commande suivante et attendre patiemment, surtout si vous n'avez pas la fibre. Allez vous prendre un café, faire votre ménage ou votre sport et revenez. Pas besoin de me dire merci, ni de me lancer des fleurs, je sais déjà que je ne donne que de bons conseils.

git lfs pull

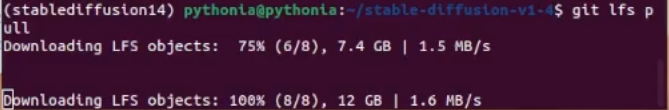

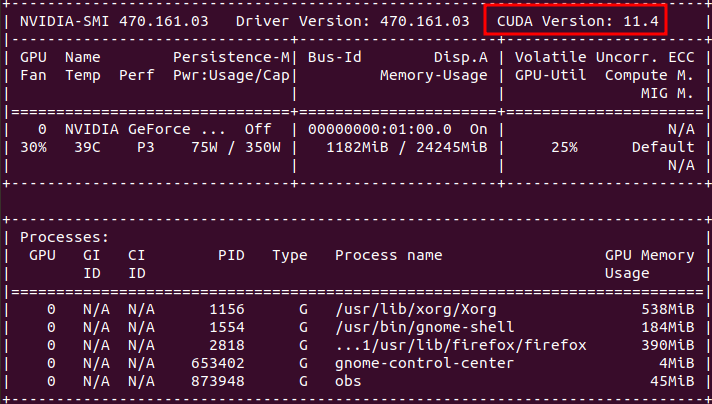

Pour cela, vous devez déjà avoir votre environnement installé, notamment avec CUDA. Comme cité en début d'article, je vous invite à vous rendre sur ce tutoriel d'installation si ce n'est pas déjà fait. Vérifiez votre version de CUDA:

nvidia-smi

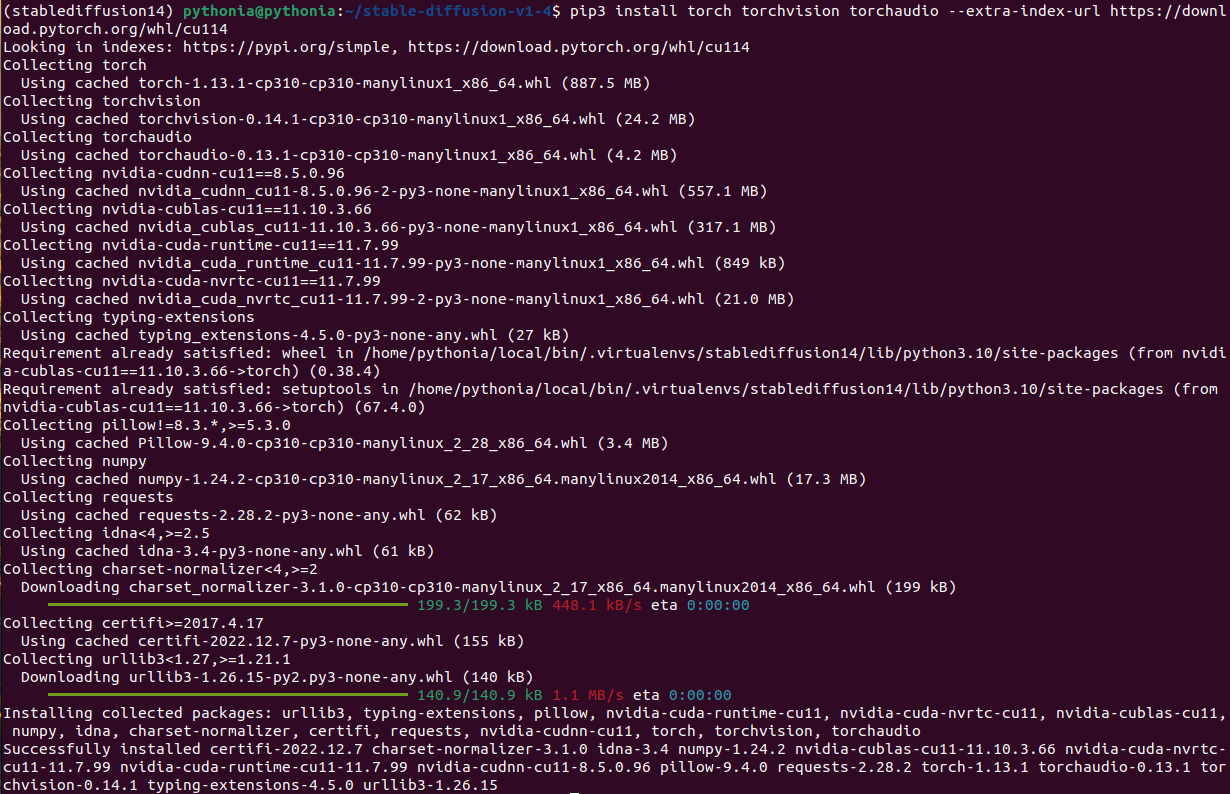

Étant donné que j'ai la version 11.4, je procède à l'installation des packages torch, torchvision et torchaudio en entrant la commande suivante. Assurez vous d'installer pytorch dans votre environnement virtuel. Pour info je suis allé chercher la commande sur le site officiel de pytorch.

pip3 install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu114

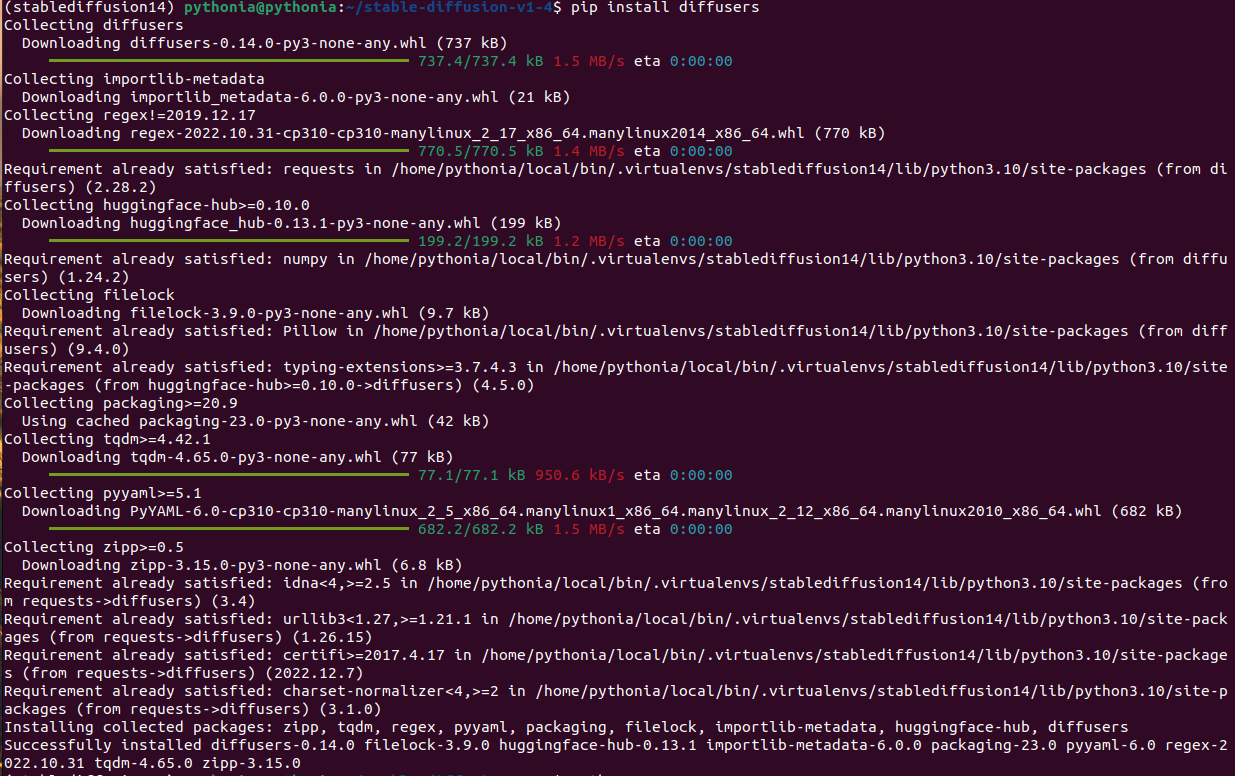

Une autre installation est nécessaire, attention, n'oubliez pas le "s" a diffusers:

pip install diffusers

Et enfin, il faut installer la librairie transformers pour la suite si vous ne voulez pas voir de malencontreuses erreurs apparaître.

pip install transformers

Une petite librairie supplémentaire pour accélérer les calculs;

pip3 install accelerate

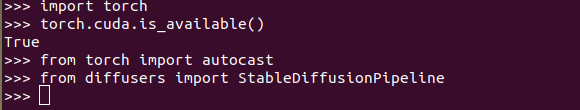

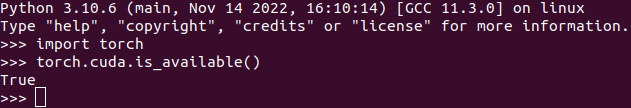

On peut maintenant vérifier que l'installation s'est bien déroulée en important torch dans python. Tapez dans votre terminal:

cd ~

python

Maintenant entrez les commandes suivantes:

# vérifier que Pytorch s'est bien installé

import torch

# vérifier que l'on accède bien au GPU pour les calculs

torch.cuda.is_available()

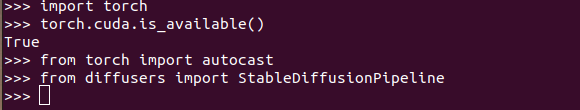

Encore un petit effort:

from torch import autocast

from diffusers import StableDiffusionPipeline

Voilà vous êtes maintenant prêt à pouvoir utiliser toute la puissance des transformers sur votre machine!

J'espère que ce guide d'installation sur Hugging Face vous a été utile et vous a permis de découvrir les outils de cette plateforme communautaire dédiée à l'IA. Si vous avez des questions ou des commentaires, n'hésitez pas à me contacter. Et si vous souhaitez en savoir plus sur l'utilisation de Hugging Facepour la création de modèles d'IA, restez à l'écoute pour la partie 2 de cet article où nous aborderons la création de notre propre script. Merci de nous avoir lu et à bientôt !

Aucun commentaire pour ce tutoriel.

Soyez le premier à réagir !