Tutoriels de Pythonia

Guides, IA, tutos et newsletter pour devenir une bête en programmation

Mis à jour le June 16, 2025, 10:40 a.m.

Tu veux faire tourner un modèle LLM en local sans avoir une machine survitaminée ? Microsoft propose une solution très prometteuse : Bitnet b1.58, un projet open source inspiré des travaux de Meta. Ce framework permet de faire de l’inférence locale avec de petits modèles quantifiés en one-bit, parfaits pour CPU ou GPU modestes.

Dans cet article, on va voir ensemble :

Ce tuto est conçu pour fonctionner même si tu débutes avec les environnements virtuels ou le deep learning. C’est parti !

Voici la video, il y a dans le tuto toutes les lignes de commandes utilisé dans la videos, c'est quand meme beaucoup plus simple de faire copier coller. Amusez vous bien !

Avant tout, on crée un environnement virtuel propre. Si tu n'as jamais créer d'environnement virtuel tu peux regarder comment en installer un sur ubuntu. Ouvre ton terminal :

mkvirtualenv Bitnet

Tu devrais avoir quelque chose comme ça:

Bitnet a besoin de clang, cmake, make, g++, etc.

sudo apt update && sudo apt install clangD'après la doc

Puis lancez la commande suivante sans oublier le sudo:

sudo bash -c "$(wget -O - https://apt.llvm.org/llvm.sh)"

Attention à ne pas oublier le "recursive" en clonant le repository:

git clone --recursive https://github.com/microsoft/BitNet.git

puis deplacez vous ds le dossier:

cd BitNet

On installe toutes les dépendances python.

pip install -r requirements.txtVoilà on est prêt à téléchargfer le modele et à le setup

On télécharge le modèle, il faut prévoir 1 à 2 GO d'espace disque selon le modèle.

huggingface-cli download microsoft/BitNet-b1.58-2B-4T-gguf --local-dir models/BitNet-b1.58-2B-4T

On lance l'installation, ça va prendre un petit moment, vous pouvez prendre un café, ou lire un livre, ou réparer votre voiture.

python setup_env.py -md models/BitNet-b1.58-2B-4T -q i2_sUne fois le modèle installé, on peut tester l’inférence :

python run_inference.py -n 512 -m models/BitNet-b1.58-2B-4T/ggml-model-i2_s.gguf -p "You are a helpful assistant" -cnvJ'ai mis une réponse à 512 tokens générées mais vous pouvez ajouter -n 1024 pour une réponse encore plus longue. A vous de tester!

Exemples :

Hello, my name is Alex → réponse OKComment utiliser les LLM pour m'aider ? → réponse approximative en français

clang sinon la compilation planteraBitnet est parfait pour lancer des LLMs localement sans infrastructure complexe. Léger, rapide, pratique pour prototyper ou apprendre.

Tu veux un article sur :

Démande-le ou écris le dans les commentaires youtube ou en bas de cet article!

Est-ce que Bitnet fonctionne sous Windows ?

Oui mais je vous recommande Ubuntu très fortement !

Peut-on utiliser d'autres modèles ?

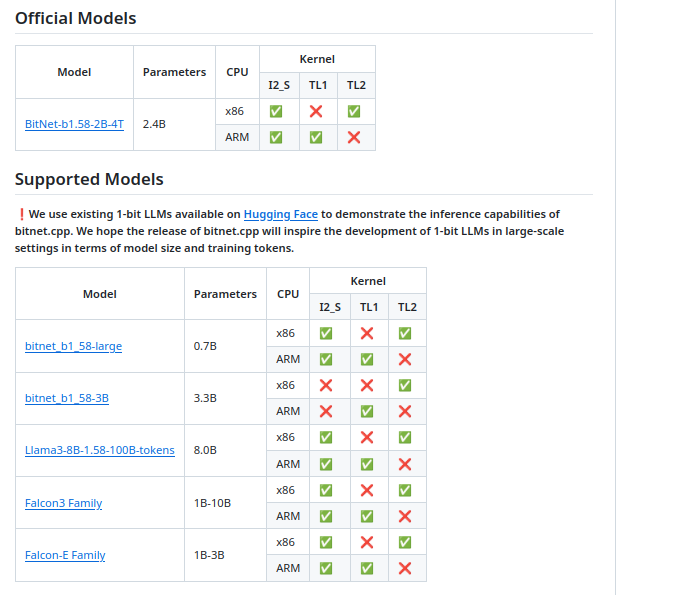

Oui. Change le nom avec -m ou utilise Hugging Face. Voici les autres modèles supporté

Bitnet est-il open source ?

Oui, sous licence MIT.

https://arxiv.org/abs/2402.17764

https://www.pythoniaformation.com/blog/articles-sur-python/tutoriels-installation-python/installer-virtualenv-ubuntu-22-04

https://github.com/microsoft/BitNet

Aucun commentaire pour ce tutoriel.

Soyez le premier à réagir !